拉取仓库 & 示例模型下载

注:运行过程中产生的问题请查阅Q & A,实在解决不了,再在微信群聊中咨询助教和老师!

本节目录

1. 拉取引擎仓库

git clone https://github.com/InfiniTensor/InfiniLM

注:有时候网络质量不好导致拉取超时,则可以尝试等网络质量好的时候再下载!

此步骤结束后,应该如下所示:

# PS: 有美元符的代表命令,没有的代表输出

$ ls

InfiniLM

然后我们需要将分支切换一下:

$ cd InfiniLM

$ git switch version1

之后确认一下我们的操作没问题:

$ git branch

main

* version1

2. 下载模型

下载命令

注:此部分以“TinyLlama-1.1B-Chat-v1.0”模型为例,此模型的源下载网站为:“ https://huggingface.co/TinyLlama/TinyLlama-1.1B-Chat-v1.0 ”(需要魔法),建议使用 “ https://hf-mirror.com/TinyLlama/TinyLlama-1.1B-Chat-v1.0 ”的镜像,下面以从镜像网站下载为例:

输入命令:

GIT_LFS_SKIP_SMUDGE=1 git clone https://hf-mirror.com/TinyLlama/TinyLlama-1.1B-Chat-v1.0

参数解释:

GIT_LFS_SKIP_SMUDGE=1:跳过 LFS 的 smudge 操作,即跳过 LFS 的文件预处理操作。

因为模型中,有一个“模型参数”文件,其占用磁盘较大,示例占了 2.2G,导致 git 拉取时,极其容易超时,所以使用此参数跳过此文件,之后我们手动对需要用 LFS 下载的文件进行下载。

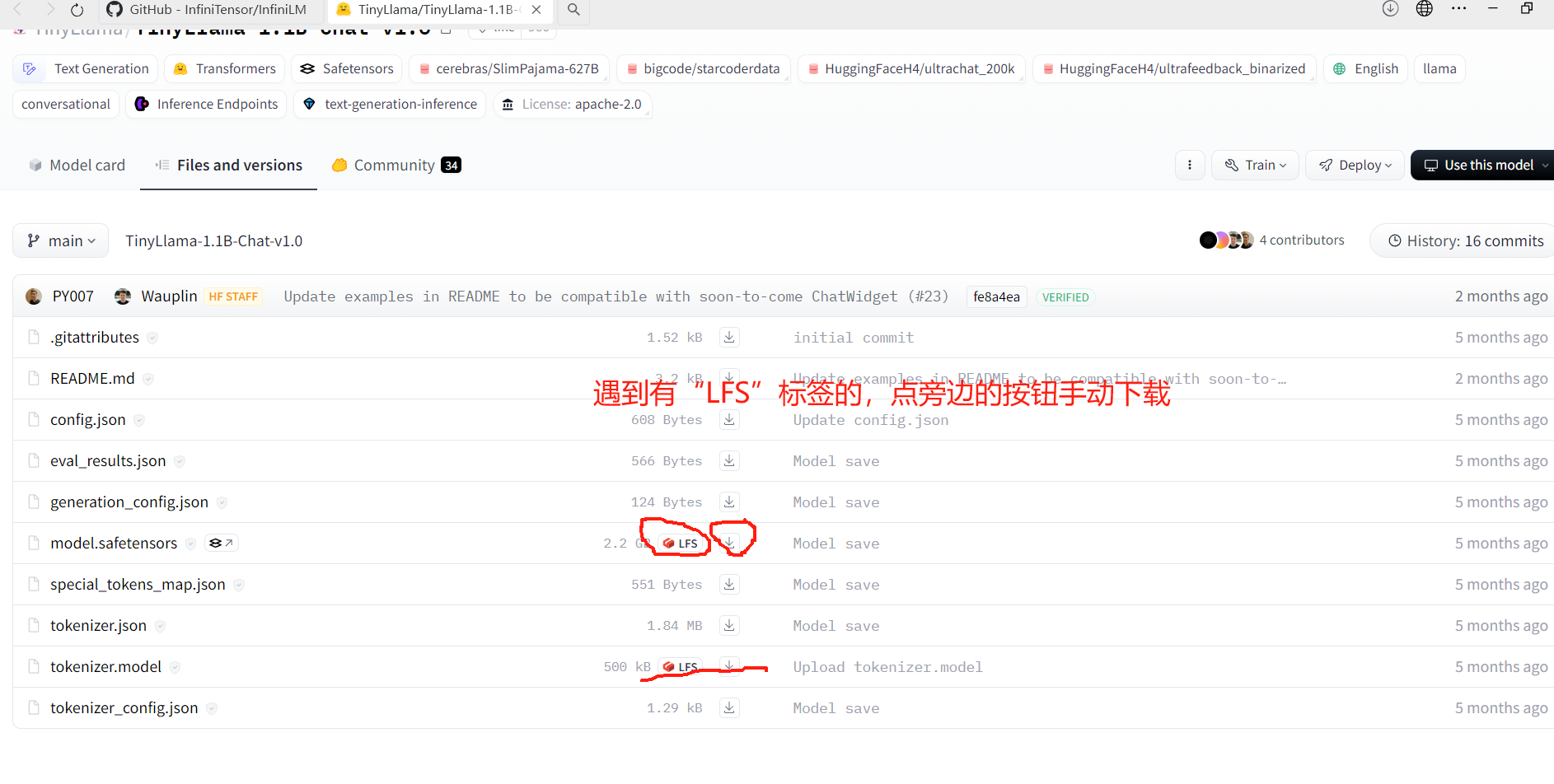

手动下载方式:

在镜像网站上,点击下面框起来的内容:

注:手动下载的两个文件,一定要放置到刚刚用 git 下载的目录里!

完成标志

在某一文件夹内,存放有拉取到的模型:

./TinyLlama-1.1B-Chat-v1.0/

|

|-- README.md

|-- eval_results.json

|-- model.safetensors

|-- tokenizer.json

|-- tokenizer_config.json

|-- config.json

|-- generation_config.json

|-- special_tokens_map.json

|-- tokenizer.model